Am 07. Mai hat Google im Rahmen der Google IO 2019 im Rahmen der Eröffnungskeynote – wie schon in den Jahren zuvor – viele Neuerungen vorgestellt. Die (für mich) interessantesten möchte ich euch hier einmal vorstellen:

AR

Im Bereich Augmented Reality hat Google einige coole Sachen präsentiert.

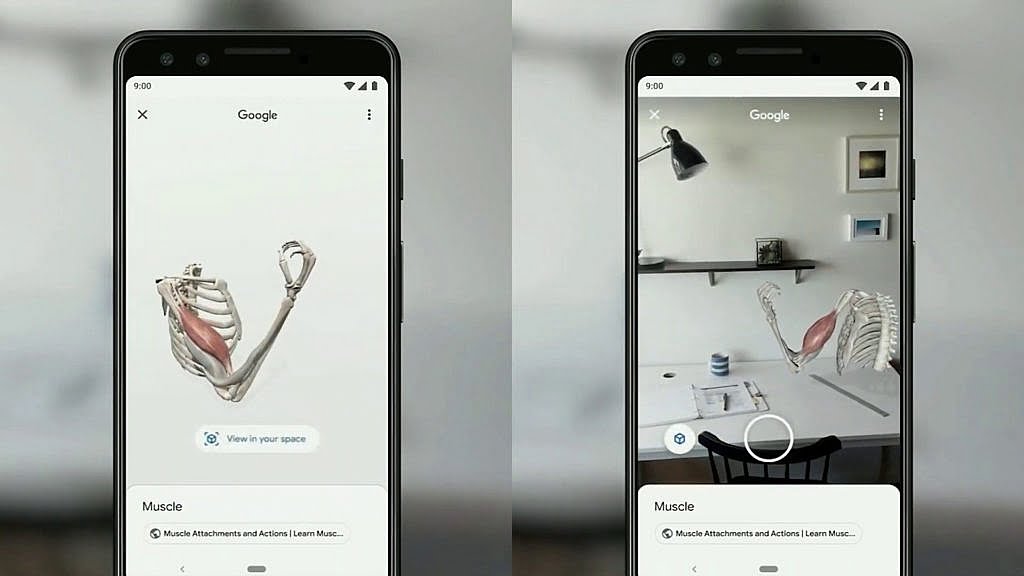

Bereits ganz am Anfang der Keynote wurde gezeigt, dass man nun in der Google Suche manche 3D-Modelle finden kann, die sich dann mit AR in die eigene Umgebung einblenden lassen. Präsentiert wurde dieses Feature anhand einer 3D-Animation der Beuge-Bewegung eines Arms.

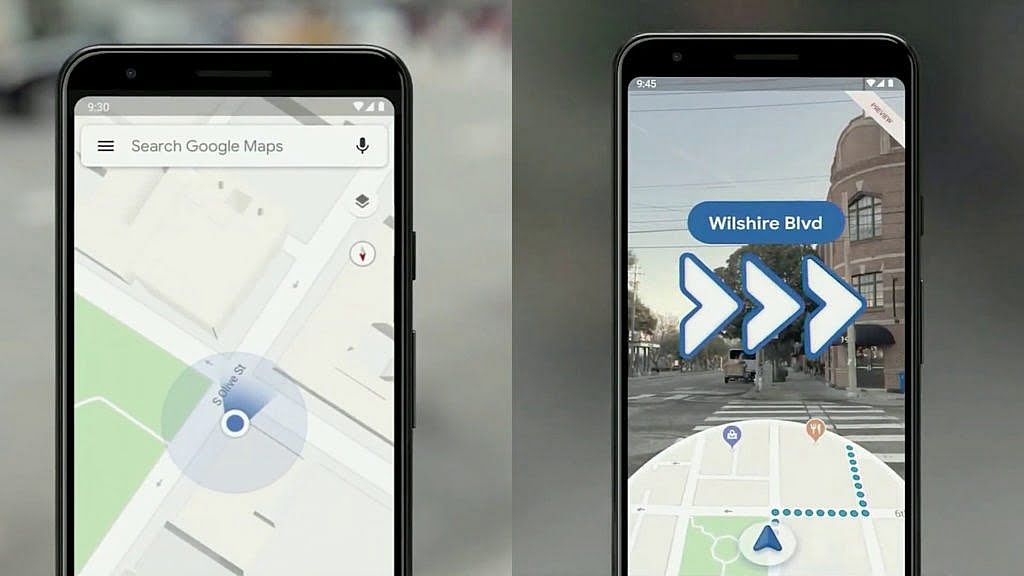

Außerdem wurde der Start der AR-Navigation in Google Maps offiziell verkündet. Dank AR-Einblendungen in der Fußgänger-Navigation findet man leichter den Weg und läuft außerdem nicht mehr Gefahr, gegen einen Laternenmast oder ähnliches zu laufen, nur weil man gerade aufs Handy guckt, um den Weg zu finden.

Google Assistant

Auch rund um den Google Assistant wurden viele neue Funktionen vorgestellt. Nachdem Google im letzten Jahr mit Duplex eine Funktion vorgestellt hat, die es dem Assistant ermöglicht, Telefongespräche zu führen (z.B., um einen Friseurtermin zu buchen), wurde dieses Mal mit “Duplex on the Web” eine ähnliche Funktion vorgestellt, mit der der Assistant nun Webformulare automatisch ausfüllen kann. Als Demo diente hier das Buchen eines Mietwagens.

Eine besonders nützliche Verbesserung besteht darin, dass die Spracherkennung des Google Assistant jetzt komplett auf dem Smartphone und ohne eine Verbindung zur Cloud laufen kann. Dadurch ist die Spracherkennung (nach Googles Angaben) bis zu 10 mal schneller. In der Demo auf der Bühne funktionierte das tatsächlich extrem zügig und auch das Aneinanderreihen von einer Handvoll Befehle im Abstand weniger Sekunden ohne eine erneutes “Hey Google” lief wie am Schnürchen.

Damit der Google Assistant sich im persönlichen Umfeld des Nutzers halbwegs auskennt, wird man in Zukunft in den Einstellungen Informationen zu Personen wie Eltern oder Geschwistern hinterlegen können. Dadurch soll der Assistant für Anfragen wie “Wie ist das Wetter bei Mama” oder “Erinnere mich eine Woche vor Mamas Geburtstag daran, ein Geschenk zu kaufen” den nötigen Kontext erhalten.

Der neue “Driving Mode” bringt auch für Autos ohne Android Auto einige smarte Funktionen und bietet schnellen Zugriff auf Navigation, Kontakte und Musikwiedergabe. Außerdem kann er bei anstehenden Terminen eine Route zum Ort des Termins vorschlagen. Im Navigationsmodus ist außerdem automatisch die Sprachaktivierung aktiv und bei eingehenden Anrufen fragt der Assistant nach, ob man den Anruf annehmen will. So können beide Hände am Steuer bleiben, wo sie beim Fahren ja auch unbedingt hingehören.

Und wo wir gerade eh schon beim Thema Navigation waren: Google Maps bekommt einen Inkognito-Modus spendiert. Solange man im Inkognito-Modus ist, werden Standort und Suchen in der Maps App nicht aufgezeichnet.

Funktionen für Menschen mit Einschränkungen

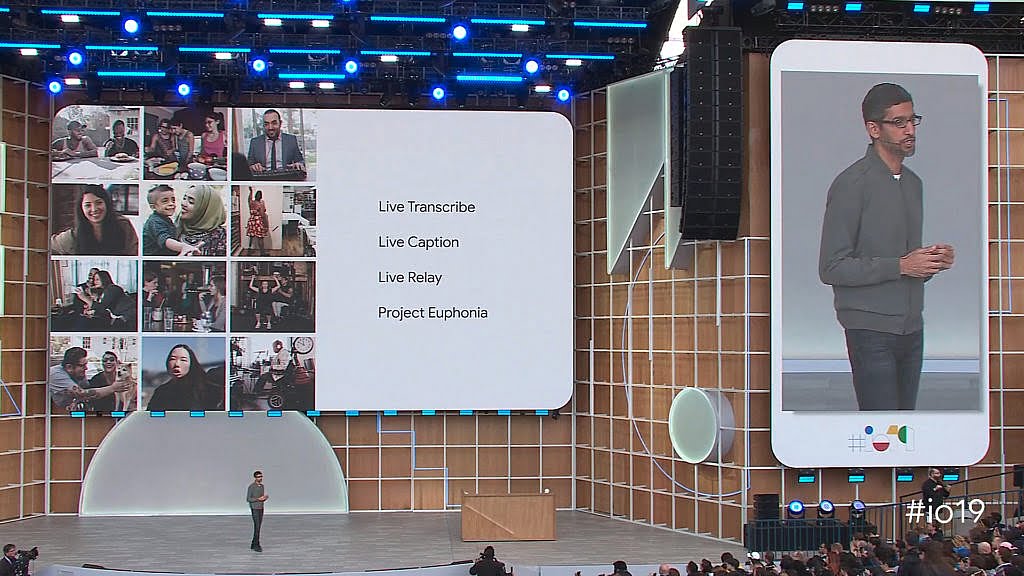

In der Keynote hat Google auch einige Funktionen speziell für Menschen mit Einschränkungen vorgestellt:

- Live Transcribe: Diese Funktion richtet sich vor allem an Personen, die nicht oder nicht gut lesen können, also zum Beispiel Menschen mit Sehbehinderung oder Analphabeten. Über die Kamera wird die Umgebung erfasst und erkannter Text hervorgehoben, der dann auf ein Tippen hin vorgelesen wird.

- Live Caption: Diese Funktion erstellt live Untertitel zu Videos. Dadurch können auch Taube den Inhalt von Videos ohne Dolmetcher oder manuell erstellte Untertitel verstehen. Außerdem ist das natürlich auch praktisch, wenn man in Gesellschaft anderer ohne Kopfhörer ein Video gucken will, da man so den Ton abstellen und den Inhalt trotzdem verstehen kann.

- Live Relay: Diese Funktion richtet sich ebenfalls an Taube und Taubstumme. Ähnlich wie bei der Duplex-Funktion des Google Assistant werden hier Anrufe durch den Assistant getätigt. Dabei wird allerdings das Gesagte des Gesprächspartners live in Text übertragen und der Nutzer kann dann per Texteingabe antworten. Diese wird dann vom Assistant dem Gesprächspartner vorgelesen.

- Project Euphonia: Nicht alle Menschen sind in der Lage, klar und deutlich zu sprechen. Schlaganfälle und Kehlkopfoperationen sind nur zwei von vielen Gründen für eine schwer verständliche Aussprache. Bei Projekt Euphonia will Google Sprechproben von Menschen mit genau diesen Problemen sammeln, um damit die Spracherkennung verbessern zu können.

Android Q

Natürlich war der Vorausblick auf die nächste Android-Version ein wichtiger Bestandteil der Keynote.

Nachdem mit Samsung und Huawei bereits zwei große Hersteller faltbare Smartphones vorgestellt haben, liefert Google in Android Q nun androidseitig die Unterstützung für diese neue Geräteklasse. Dazu gehören die Durchgängigkeit des Nutzungserlebnis zwischen dem inneren und äußeren Display (Continuity) sowie Verbesserungen beim Multitasking.

Das weiter oben erwähnte Live Caption-Feature wird mit Android Q Einzug halten und direkt über die Lautstärkeeinstellungen zugänglich sein. Dank der neuen Smart Reply-Funktion kann man nun auf Benachrichtigungen beliebiger Messenger-Apps direkt und mit vorgeschlagenen Antworten und Emojis reagieren. Beide Funktionen brauchen keine Verbindung zum Internet, da die KI-Funktionen lokal auf dem Gerät ausgeführt werden.

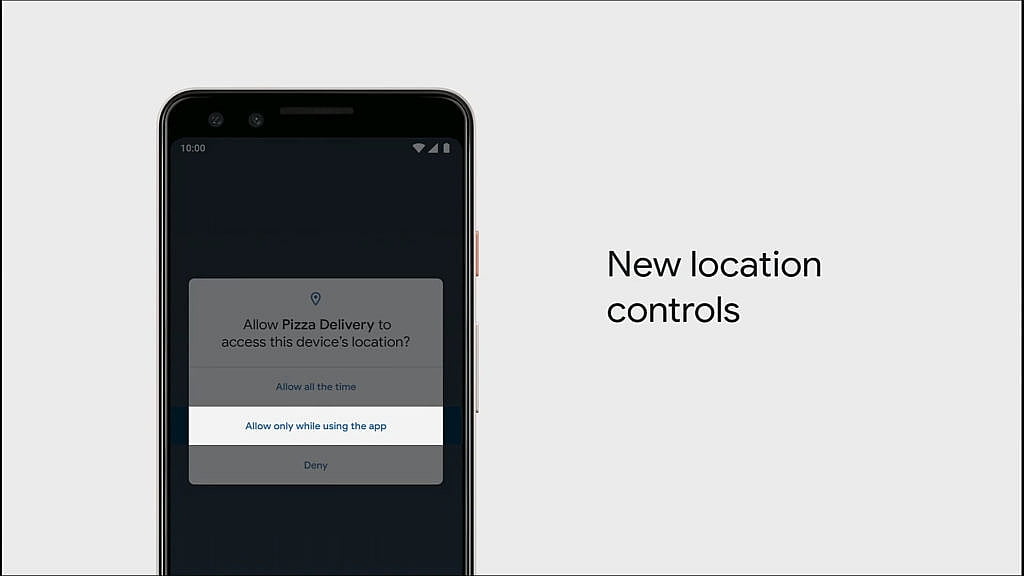

In Android Q werden außerdem die Berechtigungen für die Verwendung der Positionsdaten verbessert. Man bekommt nun eine Benachrichtigung, wenn eine App, die man gerade nicht aktiv nutzt, auf die Positionsdaten zugreift. Außerdem kann man einstellen, dass eine App nur dann Zugriff auf diese Daten haben soll, wenn sie gerade geöffnet und im Vordergrund ist.

Eine weitere wichtige Änderung ist der Verteilmechanismus für Sicherheitsupdates. Bisher muss man immer darauf warten (und hoffen), dass der Gerätehersteller die aktuellen Sicherheitspatches via OTA-Update bereitstellt. Das soll sich mit Android Q ändern. Wesentliche Sicherheitsupdates für Android sollen nun direkt über den Play Store verteilt und installiert werden. Die Sicherheitsupdates sollen dabei im Hintergrund heruntergeladen und installiert werden, so dass der Nutzer nicht dadurch gestört wird.

Ganz besonders freue ich mich auf ein neues Feature, das Google mit den Funktionen zum Digital Wellbeing bereits in Android 9 vorbereitet hat: Der Focus Mode. Dieser soll einem bei der Arbeit helfen, indem er Ablenkungen durch das Smartphone reduziert. Man kann die Apps markieren, die man als Ablenkung empfindet, und deren Benachrichtigungen werden dann gesperrt, bis man den Modus wieder deaktiviert.

Und à propos Ablenkung: Damit die jüngsten Mitglieder der Familie nicht immer nur vor dem Smartphone hängen, sind ab Android Q die Funktionen zur elterlichen Kontrolle wie Nutzungszeit und Co. direkt in den Systemeinstellungen verbaut. Diese integrieren sich jetzt auch mit den Digital Wellbeing-Funktionen, so dass Eltern auch nachsehen können, mit welchen Apps ihre Kinder wie viel Zeit verbringen.

Android Q Beta

Die Android Q Beta ist mit der Ankündigung im Rahmen der Keynote nun offiziell gestartet. Neben allen Pixel-Modellen sind auch die Geräte von 12 OEMs dabei. Zu den insgesamt 21 Modellen gehört auch das Nokia 8.1, das ich hier im Blog ja schon ausführlich getestet habe. Sobald das OTA-Update für die Beta verfügbar wird, werde ich mir die Beta auf jeden Fall einmal anschauen.

Hardware

Neben allerlei Software und künstlicher Intelligenz hat Google auch ein paar neue Geräte vorgestellt. Dank einer Unmenge an Leaks, für die Google inzwischen ja schon fast bekannt ist, waren die meisten Details zu den Geräten allerdings schon vorher durchgesickert.

Nest Hub Max

Mit dem Nest Hub Max hat Google eine 10″ Version des 7″ Home Hub vorgestellt. Der Nest Hub Max kann alles, was der Home Hub kann, bringt allerdings noch ein paar Zusatzfunktionen mit.

Zum einen verfügt das Gerät über Gesichtserkennung. Dank dieser zeigt das Display nur dann persönliche Informationen an, wenn der entsprechende Nutzer auch im Sichtbereich ist. So schafft man etwas Privatsphäre und ermöglicht gleichzeitig die Nutzung der Einblendungen von Kalenderereignissen u. a. durch mehrere Nutzer parallel.

Außerdem ist die Kamera des Nest Hub auch als Indoor-Sicherheitskamera nutzbar. So kann man auch von unterwegs einen Blick ins heimische Wohnzimmer werfen, falls man sich Sorgen macht.

Mit 229$ ist der Nest Hub Max ganze 100$ teurer als sein 7″ Vorgänger vom letzten Jahr, dessen Preis gerade auf 129$ gesenkt wurde.

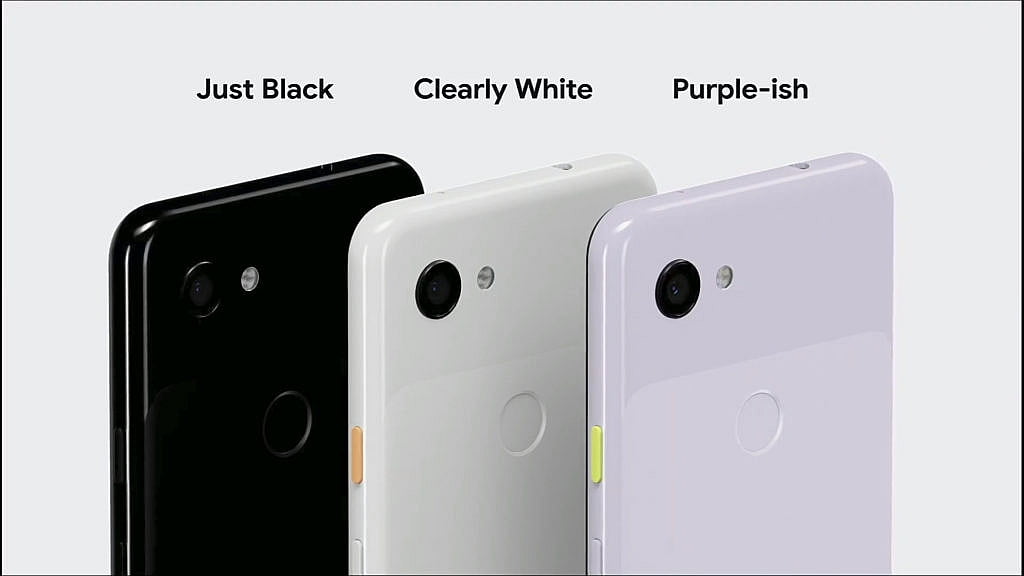

Pixel 3a und 3a XL

Das Pixel 3a und das 3a XL sind die abgespeckten Versionen der im Herbst vorgestellten Pixel 3 und 3 XL.

Das bei einem Preis von 399$ gegenüber dem großen Bruder irgendwo gespart werden musste, versteht sich von selbst. Statt aus Glas besteht das Gehäuse beider 3a Modelle aus Kunststoff; statt des Snapdragon 845 kommt nur ein 670 zum Einsatz, dem mit 4GB allerdings gleich viel RAM zur Seite steht; statt der 128GB ist der Speicher allerings nur 64GB groß.

Wenig gespart wurde bei den Kameras. Die Hauptkamera auf der Rückseite ist mit der des großen Bruders identisch, allerdings gibt es keine zwei, sondern nur eine Frontkamera. Mit einem Aufnahmewinkel, der zwischen dem der regulären und dem der Weitwinkelkamera des Pixel 3 liegt, hat man sich hier allerdings für einen – wie ich denke – guten Kompromiss entschieden.

Ein Feature, das viele beim Pixel 3 vermutlich vermissen, bringen die 3a Modelle allerdings wieder mit: die 3.5mm Klinkenbuchse.

Insgesamt scheinen mir das Pixel 3a und 3a XL sehr interessante Geräte zu sein. Ein Smartphone, das bessere Fotos macht als diese beiden, dürfte man in diesem Preissegment wohl vergeblich suchen.

Zum Schluss

Wie ich eingangs bereits erwähnte, wollte ich euch hier nur die für mich interessantesten Neuerungen vorstellen. Damit ist natürlich klar, dass ich hier einiges ausgespart habe. Falls ihr noch mehr über die Keynote wissen wollte, möchte ich euch zwei Videos ans Herz legen:

Falls ihr euch nun doch die Zeit nehmen wollt, die Keynote nachzuschauen, findet ihr sie hier eingebettet. Mit 1:50h Länge ist sie allerdings nicht gerade kurz.

Wem 1:50h zu lang sind, dem möchte ich den Zusammenschnitt von The Verge empfehlen. Mit 13 Minuten Länge ist das auf jeden Fall schon mal deutlich leichtere Kost und das Wichtigste ist – denke ich – mit drin.

1 comments On Zusammenfassung: Google IO 2019 Keynote

Pingback: Zusammenfassung: Google IO 2019 Keynote - ahahn94's Blog ()